2022年6月6日から10日まで開催されたWWDC22で、Appleは「ARKit6」を発表しました。

ARKitとは、iOSとiPadOSにおけるAR機能です。開発者向けのARフレームワークも用意されており、これを用いてARアプリを制作することが可能です。

この記事ではARKitの最新バージョン「ARKit6」でどのようなことができるのかをまとめました。参考にしてください。

最新バージョンARKit6とは?

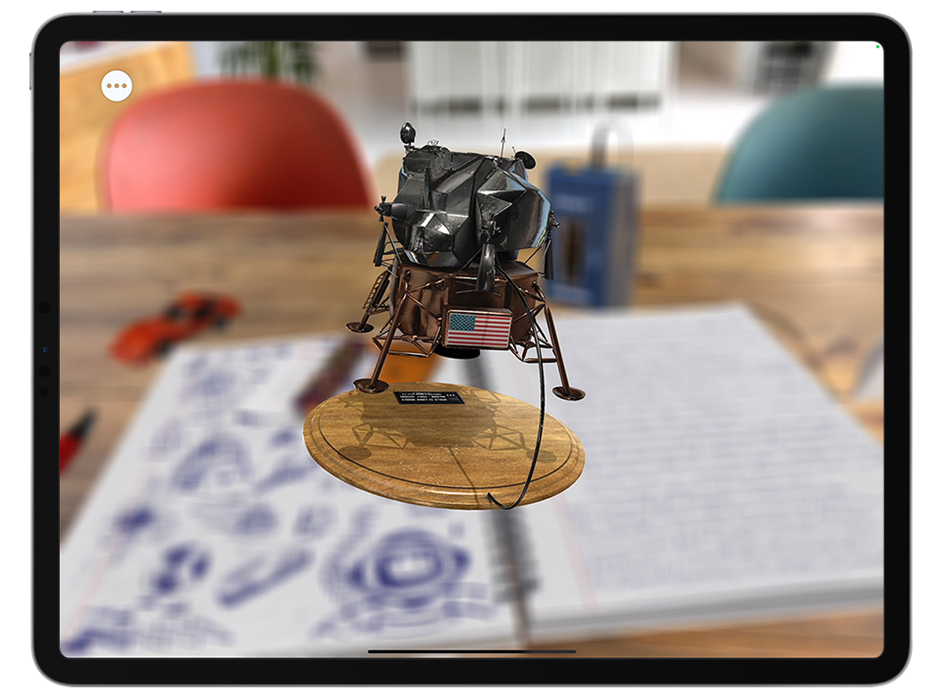

<引用画像:Apple>

ARKit6は従来まで使用されていた「ARKit5」の機能に加え、ARを表示するフレームワークに様々なアップデートが追加されています。

特にビデオとキャプチャ機能が拡張されたことにより、様々なAR表現が可能になりました。

またiPhoneのPro以上のモデルには、LiDARスキャナと呼ばれるセンサーがついています。

ARKit6はLiDARスキャナを利用した機能が多いことが特徴です。

またARKitはiOSにしか対応していないため、Androidでは利用できません。

▼公式サイト ARKit6 Apple Developer

https://developer.apple.com/jp/augmented-reality/arkit/

※LiDARスキャナとは?

LiDARスキャナは、レーザー光の反射を利用して、モノや地形の「距離」を読み取る機能です。これにより、iPhoneのカメラの機能が向上したり、現実のモノの大きさが計測できたり、3Dスキャンアプリを活用できたりと、さまざまな用途に利用できます。

ARKit6でどんなことができるのか?

<引用画像:Apple>

ARKit6は、2022年6月にAppleから発表されました。

| ARKit6の対応機種 | iPhone11以降またはiPad Pro(第5世代) |

| ARKit6のサポート範囲 | すべてのサポート対象デバイスのiOS16に含まれている |

・4Kビデオでの動画撮影

<引用画像:Apple>

AR体験中に4Kビデオでの動画撮影が可能になりました。SNSでの共有やコンテンツ作成時により高品質な映像を提供できるでしょう。

※注意

ARKit6を用いた4K動画を利用するには、必要なデバイスや環境が揃っていることが条件です。(Xcode14をインストールする、互換性のデバイスにiOS16をインストールするなど)

アスペクト比は16:9で撮影すること。また長時間のAR撮影を行う場合、ARの更新が止まる恐れがあるのでご注意を。

・画像とビデオのキャプチャ機能強化

<引用画像:Web AR Lab.>

Object Captureの機能は、対象物の周りを1周しながらいろんな角度で写真を撮影することです。

またHDRモードのビデオに対応し、露出やホワイトバランスといったEXIFタグをARKitフレームに追加することが可能です。

EXIFタグを追加することによる利点は、撮影後に画像をレタッチする際、必要な情報を持たせることができます。

HDRモード対応の利点は、晴天の雲などは非常に明るいためつぶれてしまうことが多いですがARKit6でははっきりと撮影することができます。

・Depth API

LiDARスキャナを利用することによって、周囲の環境についての深度情報がピクセル単位で利用可能になります。

※注意

Depth APIを利用するには、LiDARスキャナが搭載されたデバイスが必要です。

・インスタントAR

LiDARスキャナを利用して、平面を素早く検出、ARオブジェクトを即座に配置できます。

コード変更の必要はありません。

※注意

インスタントARを利用するには、LiDARスキャナが搭載されたデバイスが必要です。

・シーンジオメトリ

地形図を作成し、床、壁、窓などを認識してラベルを貼り付けることが可能です。

バーチャルオブジェクトに対するオブジェクトオクルージョンや現実世界の物理シミュレーションの適用が可能になり、ARのワークフローを充実させるための情報をより多く得られます。

・ピープルオクルージョン

ARコンテンツが現実世界に実在する人の前や背後を通り過ぎるといったことを実現できます。

これにより、AR体験がより臨場感あふれるものになり、ほぼすべての環境でグリーンスクリーンのような効果を得ることができます。

iPhone 12、iPhone 12 Pro、iPad Proでは、ARKitで構築されたすべてのAppで深度測定の機能が向上します。コード変更は必要ありません。

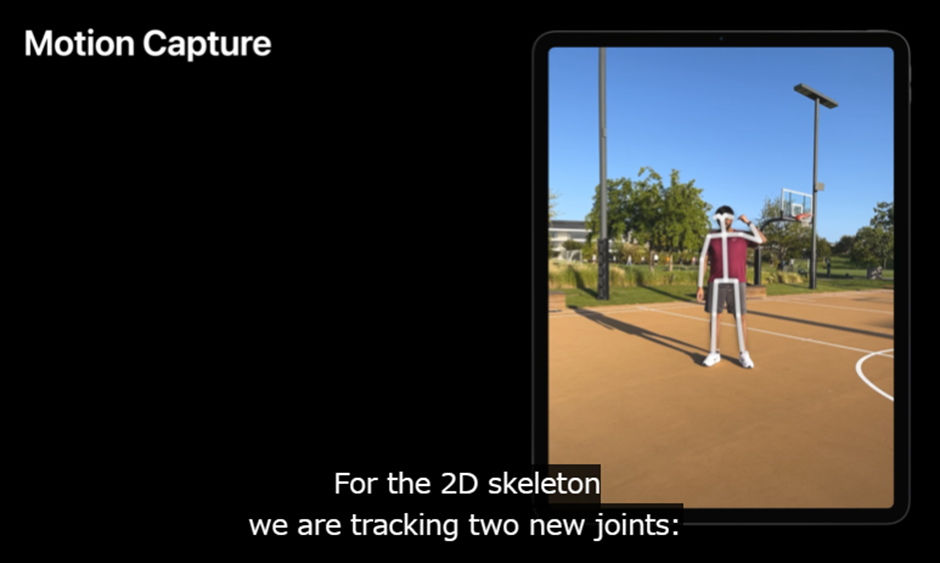

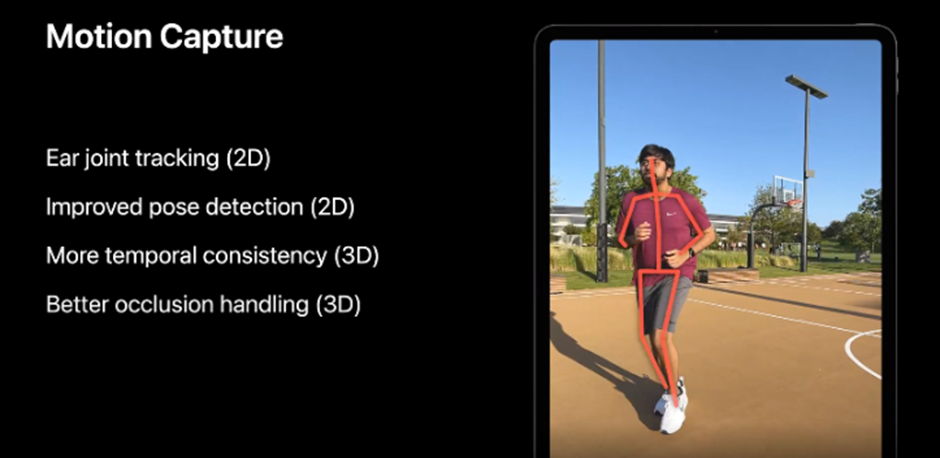

・モーションキャプチャ

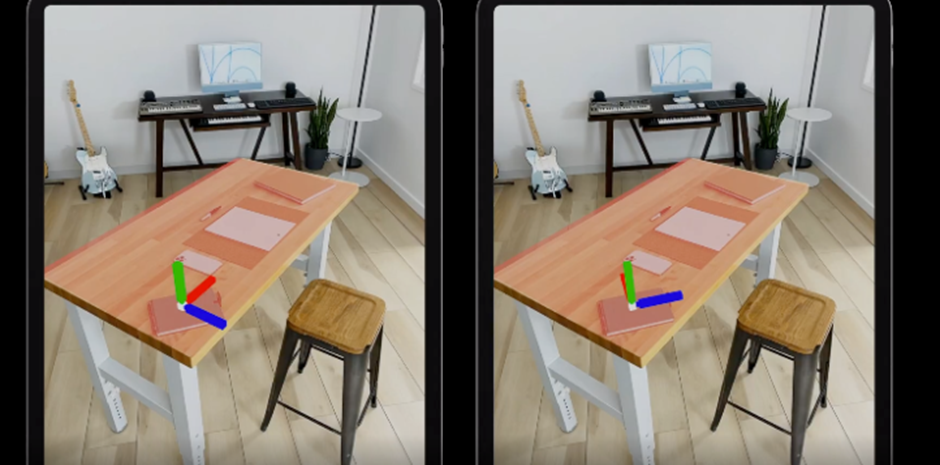

<引用画像:動画Discover ARKit 6 より抜粋>

単体のカメラでの人の動きの検出がリアルタイムにできるようになりました。そして体全体のポーズ検出精度が改善されたため、モーションキャプチャの精度が向上しました。

iPhone12、iPhone12Pro、iPadProでは、コードの変更なしでARKitで構築された高度測定機能が向上します。

・フロントカメラとバックカメラの同時使用

フロントカメラとバックカメラを同時に使用することができるようになりました。

これにより、フェイストラッキングとワールドトラッキングを同時に使える可能性が出てきました。

・その他の改善

<引用画像:Web AR Lab.>

モーションキャプチャで左右の耳のトラッキングが可能になりました。最大100枚の画像を一度に検出して、画像内のオブジェクトの物理的に自動測定が可能です。

認識精度が向上し、ブレの低減も行われます。また動き回っても、ボーンがぶれることなく追従することが可能になりました。

・平面認識の精度が向上

<引用画像:動画Discover ARKit 6 より抜粋>

平面認識を行う機能「プレーンアンカー」の精度が向上しました。具体的にはアンカー角度や平面の縦・横幅など、様々なパラメータが取得できるようになりました。

・対象地域が拡大「ロケーション・アンカー」

<引用画像:動画Discover ARKit 6 より抜粋>

Location Anchors(ロケーション・アンカー)とは、実在する場所にCGのオブジェクトを置くことができ、みんなが同じ場所でオブジェクトを見ることが可能です。

Appleが提供する、GPS、地図データ、端末のコンパスを使用して、屋外での位置追跡を可能とする機能です。

ロケーション・アンカーに対応している地域はアメリカ全土とイギリスのロンドンのみでしたが、今回次の地域が追加されました。

・バンクーバー

・トロント

・モントリオール

・シドニー

・メルボルン

・シンガポール

また日本の地域も新たに追加されています。ARKit6でロケーション・アンカーに追加された日本の地域は下記の7都市です。

・東京

・福岡

・広島

・京都

・名古屋

・大阪

・横浜

海外の一部地域はARKit4から利用できていましたが、今回初めて日本の地域を一部利用できるようになり、日本に居ながら新たなAR体験ができるようになりました。

他にも今年の追加都市としてニュージーランドのオークランド、イスラエルのテルアビブ・ヤフォ、フランスのパリが予定されています。

ARKit6の注目機能 Room Plan

RoomPlanは、Appleが2022年6月に発表した新たなスキャン技術です。ARKit6のAPIとして提供されています。

RoomPlanはiPhoneのカメラ機能とLiDAEスキャン機能を利用して、家具の寸法や種類などの特性を含む、部屋の3D平面図を作成することが可能です。

RoomePlanを利用すると、壁や家具を認識したうえで、白いモデルを生成することができます。

認識するものは、

- ストレージ

- ストーブ

- ベッド

- シンク

- トイレ

- お風呂

- 机

- ソファ

- 椅子

- スクリーン

- 階段など

生成したモデルはUSDまたはUSDZの形式で出力できます。

出力したモデルを使って、ARでの表示やモデリングソフトにより加工することも可能です。

RoomPlanは不動産の販売やリフォームのイメージ共有、eコマース販売における販促、インテリアのデザイン、メンテナンス業務でのアシスタントに活用できるのではないでしょうか。

またRoomPlanはAPIなので、個別アプリに組み込むことが可能です。

▼YouTube動画 Apple RoomPlan API — WWDC 2022

まとめ

いかがでしたか?この記事ではARKit6でどのようなことができるのかをまとめました。

ONETECHでは、LiDARスキャンを利用した測定、また3Dデータの制作に対応しています。ONE TECHでの3Dデータ制作実績を下記にまとめました。ご相談する際の参考にしてください。

▼3Dデータ制作実績

メタバースでのショッピングのための自動車CG制作 | ONETECH開発実績

住宅、マンション3Dシミュレーション「HOUSE DECOR」追加改修 (onetech.jp)

ほかにもONETECHはベトナムオフショア開発で受託開発も請け負っております。幅広い分野で開発してきた実績がありますので、ソフトウェア開発のご相談はぜひOne Technology Japanへお気軽にお問い合わせください。